现存的大模子实在都是在Tranformer的基础上拓荒的,不错说Tranformer即是大模子的基石。这篇著作,作家给咱们全球先容了Tranformer的研究学问,一皆来望望。

查阅大模子研究汉典时,频繁看到NLP、LLM、GPT、ChatGPT、Transformer……这些都是什么呢,之间又存在什么关连呢?

一、关连初识

NLP当然话语处理,是东谈主工智能边界的一个分支,是一种学科/应用边界。而LLM大型话语模子,是NLP边界中的一种特定类型的话语模子,是指一个泛泛的分类,涵盖了扫数使用多数数据进行检会的、大致处理和生成当然话语的AI模子。而GPT是这一类模子中的一个特定规子,是LLM的一种竣事,通过海量数据检会的深度学习模子,大致识别东谈主的话语、本质话语类任务,并领有多数参数。它使用Transformer架构,并通过大限制的预检会,学习话语的模式和结构;ChatGPT则是基于这些内容而竣事出来供咱们使用的居品。

1.基于以上的了解,可将LLM、GPT、Transformer、ChatGPT的关连用下图暗示:

可见Transformer是基础架构,LLM是诞生在这种架构上的一类复杂系统,GPT是LLM中的一种特定竣事,并通过多数的预检会,取得了纷乱的话语处理才能。云尔发布的ChatGPT使用了GPT技能进行了居品的呈现。

2.为了更好通晓LLM、GPT、Transformer三者的关连,咱们可将他比作建筑的不同部分:

1)Transformer:基础结构

将其遐想为一座大楼的框架,Transformer提供了基本的撑捏和姿首,里面详备遐想为空,决定了建筑的合座遐想和功能;

2)LLM:合座建筑

可通晓为是诞生在前边框架上的合座建筑,不仅有框架(即Transformer架构),还包含了房间、电梯、遮挡等,使建筑圆善,功能丰富;

3)GPT:特定类型的建筑

可被视为大型建筑中的一种特定类型,如一座绝顶的摩天大楼,他不仅使用了Transformer架构,还通过特定的阵势进行了遐想和优化(即大限制预检会),以竣事特定的功能,如高效的文本生成和话语通晓。

二、Transformer

话语大模子的中枢是Transformer,是基于沉静力机制的深度学习模子(神经荟萃架构),用于处理序列到序列的任务。节略来说,即是捕捉句子中不同位置的词之间的关连,用于如通晓高下文信息、生成连贯逻辑一致的文本等,且能高效并行狡计。

1. Transformer主要中枢结构

如下:

Transformer里面有多个编码器、解码器堆叠;

编码器:主要捕捉输入序列中的信息并建模特征;

解码器:主要生成输出序列;

编码器/解码器堆叠的作用:增多模子性能,有助于处理复杂的输入输出关连。

底下咱们深切了解一下Transformer架构:

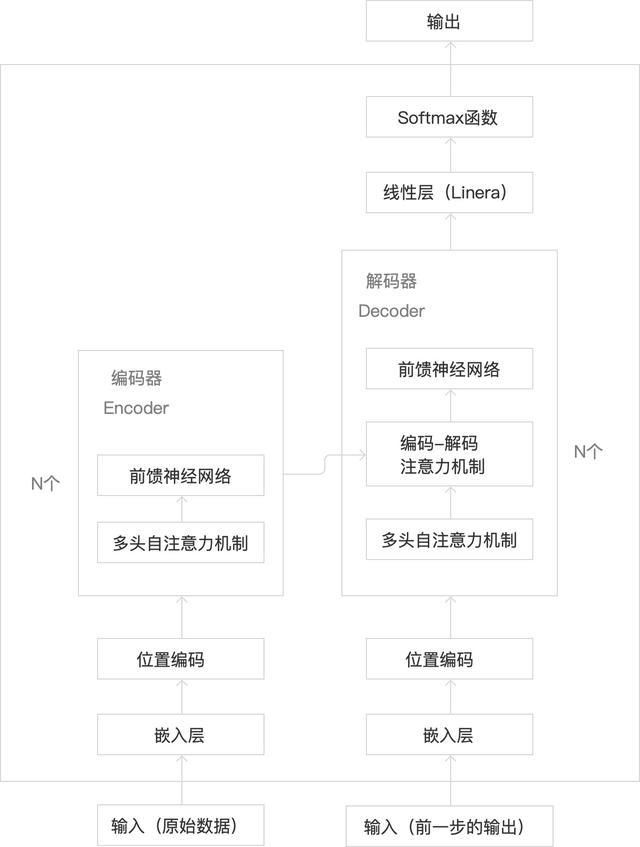

1)其中枢构成部分包含:

i.编码器:

由多个编码器层堆叠而成,里面包含多头自沉静力机制+前馈神经荟萃,合座主要作用是捕捉输入序列的高下文信息,并生成一系列编码向量;

ii.解码器:

由多个解码器层堆叠而成, 里面包含带掩码的多头自沉静力机制+编码器到解码器的多头沉静力机制(常称为编码器-解码器沉静力)+前馈神经荟萃,合座主要作用是诳骗编码器的输降生成输出序列。

iii.镶嵌层:

将输入序列中的词退换为用向量暗示(即词向量),以便模子大致处理;

词向量:

将单词退换为向量,或者说将话语的基本单元退换为数字组合(如将英文单词退换为一串数字,让狡计机可识别),中枢想想是具有相似语意的词在向量空间中更接近;

向量:暗示具有大小和场所的量,如在直角坐标系中(x,y)、在三维空间暗示为(x,y,z);

iv.位置编码:

把暗示各个词本文法则的向量和上一步得到的词向量相加;

由于Transformer并行处理输入序列中的扫数单词,是以不知谈输入序列的法则信息,因此需要生成每个单词在序列中的位置信息;

2)主要波及的职责旨趣:

i.自沉静力机制:

允许模子在处理每个单词时关怀输入序列中的其他单词,这种机制能给每个词分拨一个权重,狡计面前词与其他扫数词之间的研究性;

作用:通晓高下文和话语流的舛误(捕捉序列数据中的依赖关连);

ii.多头自沉静力机制:

将输入序列分红多个头,并对每个头进行自沉静力狡计,然后将多个头的驱散拼接在一皆,场外配资最终通过线性变化得到输出。节略的说,每个沉静头专注于句子中的某个特定关连(如某一个单头自沉静力只关怀主谓关连、另一个单头自沉静力只关怀状貌词与名词的关连等),使模子大致从不同角度或多个层面捕捉语意信息;

作用:生成更准确的暗示,擢升了对复杂关连的建模才能;

iii.前馈神经荟萃:

在每个编码器与解码器层中,还包括一个位置颓败的前馈神经荟萃,由两个线性层和一个激活函数(宽泛为ReLu)构成;

作用:对自沉静力层的输出进行进一步的非线性变换,强化位置的暗示/索要更复杂的特征,增强模子的抒发才能;

2. Transformer的里面结构

基于以上的了解,咱们来补全一下Transformer的里面结构如下:

1)编码器相等输入/出部分:

i.输入:原始的海量数据

ii.镶嵌层、位置编码:对原始输入数据进行处理

作用:将输入的词滚动为向量,并加上位置信息,供编码器使用

iii.编码器里面:

多头自沉静力:捕捉原始序列信息

前馈神经荟萃:增强模子抒发才能

iv:输出:包含了原始输入信息的高下文信息与位置信息的向量序列,是后续解码经过的基础

2)解码器相等输入/出部分:

i.输入:分为2大部分

解码器本人的输入:

开动绚丽:暗示输出序列的着手(作用:告诉解码器开动生成策划序列)

先前生成的词:指开动后,前一个期间步解码器的输出,也四肢输入(作用:为下一步掩码多头自沉静力机制提供骨子内容,如高下文信息、位置信息等)

前一期间步:指在期间序列或序列数据中,面前元素(词、字符或期间点的数据)之前的阿谁元素或期间点

编码器的输出:

编码器的输出四肢解码器的输入(作用:编码器的输出空洞了原始序诸位置与高下文信息,来疏通解码经过的沉静力分拨)

ii.镶嵌层、位置编码:仅对解码器“先前生成的词”进行处理

作用:将输入的词滚动为向量,并加上位置信息,供解码器中的多头自沉静力机制使用

iii.解码器里面:

多头自沉静力机制:详指带掩码的多头自沉静力机制,针对已生成的输出序列(指前边说的“先前生成的词”被镶嵌层与位置编码处理后的)进行处理,

(作用:疑望明天的信息被诳骗,吝啬序列生成的因果法则,确保模子生成策划序列时的连贯性与一致性)

·编码-解码沉静力机制:捕捉编码器的输出与解码器行将生成的输出序列之间的复杂依赖关连,从而将原始序列的信息和会到输出序列的生成经过中(作用:有助于解码器生成准确的策划序列输出)

前馈神经荟萃:增强模子抒发才能

iv.输出:一步步生成一个圆善的输出序列

3)线性层与Softmax函数

i.线性层(Linera):主要用于对输入数据进行线性变换,辅助数据的维度或节略的线性组合,退换维度;

ii.Softmax函数:主要用于将线性层的输出退换为词汇表的概率鉴识,选拔最可能的输出序列(词汇表的概率鉴识代表下一个词(token)被生成的概率)。

线性层+softmax函数合座作用:把解码器输出的暗示,退换为词汇表的概率鉴识(

从特征空间到最终输出驱散的退换),从而进行词汇料想和生成任务。

3. Transformer与其他神经荟萃模子的对比

1)Transformer:基于自沉静力机制的模子

大致高效处理序列数据

优点:

i.并行处理才能强:可并行处理扫数这个词序列,显贵擢升狡计驱散

ii.捕捉长距离依赖关连:能平直探询序列中的放浪位置,有用捕捉长距离(高下文)依赖关连

iii.通用性强:能处理复杂任务,不仅适用于当然话语边界,还适用于图像处理等其他边界的序列建模任务

流毒:

i.资源花消大:关于长序列处理时,狡计和内存资源需求较高

ii.检会数据量条目高:宽泛需要多数的检会数据来取得难懂的性能,绝顶是在处理复杂任务时

2)CNNs:卷积神经荟萃

主要适用于图像识别任务,索要图片的空间特征(图片中各部分之间的空间布局和相对位置,如勾搭、包含等关连)

优点:

i.空间特征索要才能强:不论图像若何转移,都能索要到一样的特征;

ii.参数分享和局部贯穿:减少模子参数数目,裁减狡计资本;

流毒:

i.无法处理序列数据:不适应捕捉长序列内的依赖关连;

ii.平移不变性:可能导致某些任务发达欠安

3)RNNs:轮回神经荟萃

主要用于处理序列数据,大致捕捉数据中的期间依赖关连,适应处理如期间序列数据(如近3个月的股票价钱数据、近一周的气温数据);

优点:

i.处理序列数据:擅所长理具有期间关连的序列数据,如文本、语音

ii.参数分享:在期间步上参数分享,减少了模子的参数数目

iii.短期牵记:大致记着短句子中前边的信息,通晓高下文依赖关连

流毒:

i.长依赖问题:难以捕捉到远距离的期间依赖关连,如长句子中距离远的词,依赖关连无法捕捉;

ii.狡计驱散低:难以并行狡计,导致检会速率较慢;

4)LSTM:是RNN的一种变体,口角期牵记荟萃

适应处理期间研究性较强的短序列数据;

优点:

i.处理永久依赖:有用处理序列处理中的永久依赖关连

ii.梯度问题:比拟RNN,LSTM更好的贬责了梯度消散/梯度爆炸的问题

流毒:

i.检会期间长:狡计复杂度高,且难以并行

ii.资源花消大:跟着序列长度的增多,检会难度与资源花消也会增多

4. 应用近况

在Transformer原始架构的基础上后续出现了变种:

主要分为3类:

1)仅编码器:如 Bert,适用于通晓话语的任务,如掩码话语建模(让模子猜被遮住的词是什么)、情谊分析(让模子猜文本情谊是积极一经抱怨)等

2)仅解码器:如GPT系列(ChatGPT),擅长通过料想下一个词,来竣事文本生成等

3)编码器+解码器:如T5、BART,适用于把一个序列退换成另一个序列的任务,如翻译、 追想等

以上即是对Transformer旨趣、结构等的节略分享,但愿不错帮到你,迎接一皆交流学习。